KI-Power made in Germany: Telekom und Nvidia starten Mega-Cloud 10.000 Nvidia-GPUs, DGX B200-Server, 12 MW Ökostrom, Start Q1 2026

Die Deutsche Telekom, Nvidia und SAP starten Anfang 2026 die „Industrial AI Cloud“ in München. Das Datacenter mit 10.000 GPUs soll KI-Kapazitäten in Deutschland um 50 % steigern und vollständig mit Ökostrom betrieben werden. Kunden sind u. a. Siemens, Agile Robots und Perplexity. Langfristig plant die Telekom eine „German AI Gigafactory“ mit 100.000 GPUs.

Deutschland bekommt eine eigene Groß-Cloud für Künstliche Intelligenz: Nvidia, die Deutsche Telekom und SAP haben den Starttermin für ihre neue „Industrial AI Cloud“ bestätigt. Das Rechenzentrum bei München soll im ersten Quartal 2026 online gehen und die KI-Kapazitäten in Deutschland um rund 50 Prozent steigern. Das Projekt gilt als eine der größten europäischen Investitionen in KI-Infrastruktur.

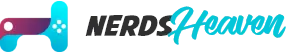

(Foto: Lisi Niesner / REUTERS)

Eine Milliarde Euro für deutsche KI-Souveränität

Die drei Partner investieren rund eine Milliarde Euro in das neue Datacenter, das im Münchner Tucherpark entsteht – unterirdisch auf dem Gelände eines ehemaligen Hypovereinsbank-Rechenzentrums. Die Kühlung erfolgt teils über den Eisbach, der parallel zur Isar verläuft.

Telekom-Chef Timotheus Höttges bezeichnete das Projekt als Meilenstein für die deutsche Industrie:

„Jetzt gibt es keine Ausreden mehr. Deutschland wird nicht überleben, wenn wir diese neue Technologie nicht nutzen.“

Die „Industrial AI Cloud“ soll speziell Unternehmen und Behörden adressieren, die auf leistungsstarke, aber in Deutschland betriebene KI-Infrastruktur angewiesen sind. Die physische Plattform stellt die Telekom, SAP liefert Software und Business-Tools, während Nvidia die Rechenleistung beisteuert.

(Quelle: Telekom)

10.000 GPUs – und alles bleibt in Deutschland

Das neue Datacenter setzt auf mehr als 1.000 Nvidia DGX B200- und RTX Pro-Server, jeweils mit acht Blackwell-GPUs pro Node. Zusammen ergibt das ein Cluster aus 10.000 GPUs mit einer theoretischen Gesamtleistung im ExaFLOP-Bereich.

Die DGX B200-Plattform basiert auf zwei Intel Xeon Platinum 8570 CPUs und acht Nvidia B200 GPUs, was pro System bis zu 72 PFLOPS für Training und 144 PFLOPS für Inferenz ermöglicht. Der Energieverbrauch liegt bei 14,3 Kilowatt pro Node, insgesamt zieht das Rechenzentrum rund 12 Megawatt, die vollständig aus erneuerbaren Energien stammen sollen.

Laut Telekom bleiben alle Daten in Deutschland, die Verwaltung erfolgt ausschließlich durch europäische Mitarbeiter – ein zentraler Aspekt des Ziels, „digitale Souveränität“ zu sichern.

Erste Kunden stehen fest

Zu den ersten Nutzern zählen sowohl Industrie- als auch KI-Unternehmen. Im B2B-Segment sind unter anderem Siemens, Agile Robots, Wandelbots, PhysicsX, EY und der Drohnenhersteller Quantum Systems an Bord. Für den Consumer-Bereich stellt die Telekom Inferencing-Kapazitäten für den KI-Dienst Perplexity bereit.

Damit soll die „Industrial AI Cloud“ sowohl für industrielle Automatisierung als auch für generative KI-Anwendungen genutzt werden – also von der Robotikentwicklung bis zur Sprach-KI.

Europäische Antwort auf US-Dominanz

Während in den USA rund 70 Prozent der globalen GPU-Kapazitäten für KI stehen, kommt Europa derzeit nur auf 5 Prozent. Das Münchner Datacenter ist daher auch ein symbolischer Schritt, um Europas Abhängigkeit von US-Infrastrukturen zu verringern.

Parallel arbeitet die EU an einem „AI Continent Action Plan“, der den Aufbau mehrerer „Gigafactories“ mit jeweils über 100.000 GPUs fördern soll. Die Telekom bezeichnet ihr Münchner Projekt als „Stage 1“ – perspektivisch soll eine „German AI Gigafactory“ mit zehnmal mehr Rechenleistung entstehen.

Einschätzung

Mit der „Industrial AI Cloud“ schaffen Telekom, Nvidia und SAP eine strategisch wichtige Basis, um deutsche und europäische Unternehmen beim Aufbau eigener KI-Systeme zu unterstützen – ohne Datenabfluss in die USA oder nach China. Der Ansatz bleibt pragmatisch: Technologie aus den USA, Betrieb in Deutschland.

Ob die geplanten 10.000 GPUs reichen, um gegen Hyperscaler wie AWS, Google oder Microsoft anzutreten, bleibt offen. Aber das Signal ist klar: Deutschland will nicht länger KI-Kunde sein – sondern Infrastrukturbetreiber.

Wie seht ihr das – ein echter Wendepunkt für Europas digitale Unabhängigkeit oder nur ein teurer Anfang?